ChatGPT類應用服務 數據合規有特殊性嗎?

發表於 2023-04-28 16:33 作者: 騰訊研究院

王融 騰訊研究院首席數據法律專家

本期觀點摘要:

1. ChatGPT等AI應用服務商直接面向個人提供服務,收集並處理個人信息,可被視爲個人信息保護合規主體——數據控制者。

2.與移動互聯網APP的典型場景相比,生成式AI服務商的個人信息處理活動有其自身特徵,數據合規重點也有所不同。

3.根據GDPR,歐盟數據保護機構(DPA)是監管機構,而非市場准入機構,其職責主要在指導督促企業滿足數據合規要求。

4.未來真正的挑战來自於AI賦能的各類應用服務,解決新的數據安全問題需要新思維。

C端AI應用服務商是

數據控制者(data controller)

並非所有的市場主體都是數據合規框架下的義務主體,需要根據技術原理、業務場景和法律規範來進一步確定。當主體身份重合時,也需基於不同業務流程匹配合規義務。基於此分析框架,我們在上一篇文章裏詳細論證了大模型研發者,在模型研發階段有可能並不認定爲隱私數據合規上的法律主體(data controller)。

基於同樣的分析框架,我們認爲面向C端個人用戶提供生成式AI服務的運營者可被認定爲隱私數據合規上的數據控制者。例如,當OpenAI在2022年11年面向公衆發布ChatGPT應用服務,並在2個月內突破1億用戶,成爲歷史上增長最快的消費者應用時,作爲數據控制者的身份已確定無疑。

事實也如此。從國外實踐看,目前已面向個人的AI應用服務商,在數據合規部分已完整配置隱私政策和用戶協議,以充分告知用戶收集了哪些類型的數據,以及如何處理數據。OpenAI在隱私政策中列舉了收集類型[1];包括账戶信息、通信內容、使用記錄等;數據處理的目的包括但不限於:提供、改進服務,預防欺詐,網絡信息安全、履行法定義務所需等。類似的,面向公衆的圖片生成AI服務商Midjourney 也提供了清晰明了的隱私政策[2]。國內目前雖然沒有正式上线的產品,但已有部分廠商在測試版本中嵌入隱私政策。

這也就不難解釋爲什么數據保護機構DPA是第一批入場的監管機構。3月31日,意大利數據監管機構Garante宣布暫時禁止ChatGPT,並要求OpenAI 在20天內相關問題作出回應[3]。這是數據監管機構DPA對一項新興應用的正常反映,但被誤讀爲DPA可以對特定業務採取永久性措施。相反,根據歐盟GDPR,DPA雖然有天價處罰權,但其職權被嚴格限制在矯正性權力範圍內,包括建議,警告以及暫時性的或者具有明確期限的禁令[4]。換言之,只要服務提供者滿足數據合規要求,則DPA不得對其採取市場禁入措施。在其臨時禁止令受到廣泛批評後,4月12日,Garante釋放信號:“如果 OpenAI 採取有效措施,我們准備在 4 月 30 日重新开放 ChatGPT”[5]。

生成式AI服務商

數據合規的獨特性

與移動互聯網相比,面向個人的生成式AI應用在數據合規上有很多相似之處,包括制定隱私政策、業務協議,明確處理用戶數據的合法性基礎,通過隱私保護設計在信息系統中支持用戶圍繞其账戶信息和使用服務過程中產生的個人信息的相關權利,包括查詢、訪問、更正、刪除等。但一方面,我們更加關注其在個人信息處理活動中的獨特性:

第一、收集的個人信息種類相對較少。導航軟件、打車、購物等典型的移動APP爲實現對用戶個性化服務的閉環,需要實時收集用戶較多類型的個人信息;而目前的生成式AI應用,以OpenAI和Midjourney爲例,從其底層邏輯出發,其更加關注生成內容的質量,在應用服務階段收集個人信息主要是建立用戶账戶體系,接受用戶指令(prompt)並與之交互,因此收集的個人信息相對較少,包括账戶信息(用戶名、郵件)、使用記錄(cookie等),如果涉及購买服務等交易,則還包括支付信息。因此,Midjourney更是以表格的形式,明確列出了不收集的用戶信息種類:包括用戶敏感信息,生物識別信息、地理位置信息等等。這些信息對於生成式AI應用確實也無關緊要。

第二、在更早階段以及更廣泛地採取個人信息去標識化以及匿名化措施。在提供服務過程中,生成式AI主要圍繞用戶账號體系及通信內容構建數據安全防護體系。以ChatGPT爲例,盡管在模型訓練階段,其採集的數據源中的用戶個人信息較少(且主要爲公开信息),但在應用服務階段,問答式的會話功能會產生較爲敏感的通信內容,模型根據與用戶通信內容(上下文環境)進一步分析並生成回復。爲降低用戶通信內容泄露後產生的風險,生成式AI會在更早階段採取用戶身份信息去標識化及匿名技術,或者將用戶身份信息與通信內容相互分離,或者在模型生成回復內容後及時刪除通信內容等安全類措施。這也是由生成式AI更關注反饋內容,而非用戶行爲的邏輯所決定,這與建立在用戶行爲特徵基礎上,以個性化推薦見長的移動APP有顯著差異。

第三、由以上兩方面影響,生成式AI與移動APP在數據安全的風險領域有所不同。移動互聯網APP需要直接收集大量個人信息,用戶數據庫易成爲黑客攻擊和數據泄露的目標。然而,在生成式AI 應用中,雖然其直接收集的用戶信息種類少,但其風險集中在模型被攻擊從而反向溯源數據庫,以及用戶通信內容泄露的隱患。意大利數據監管機構對OpenAI發出暫時禁令,即是由於用戶通信內容因出現服務bug而泄露的事故。爲減輕風險,在技術上已經明顯具備先發優勢的OpenAI,开始探索支持用戶可以選擇將個人刪除通信記錄。4月23日,OpenAI 推出新控件,允許 ChatGPT 用戶可以選擇關閉其聊天歷史記錄,且可以不用於模型訓練目的[6]。

第四、在輸出階段,如果用戶引導的問題涉及個人信息時,基於大模型的語言預測生成的算法邏輯,輸出結果中的個人信息有可能是編造的,虛假的,這可能違反了個人信息保護法上的信息質量原則,即保持個人信息准確性要求。但這類問題的背後實質是生成式AI在內容治理中面臨的一般性問題,即AI進入“幻想”,編造不准確甚至是虛假的信息。

OpenAI在研發階段,即致力於改善和解決此類問題,包括引入人類專家意見反饋機制和強化學習(RLHF),引導AI輸出准確內容。目前,部分生成類AI還加入了輸入(prompt)+輸出雙重過濾機制,來進一步避免出現有害內容或侵權問題。盡管大語言模型的進步速度令人瞠目結舌,僅用了4個月,ChatGPT 4相比於GPT3.5,其輸出信息的准確率就大幅提升了40%,違反內容政策的輸出可能性降低 82%[7],但目前仍不能保證其生成內容具有可靠的准確性。因此作爲用戶也應當對ChatGPT的回答保持一定警惕和判斷力,避免被誤導。

綜上,看待生成式AI的數據合規問題,需要從移動互聯網服務中的數據合規慣性中跳脫出來,圍繞其在隱私和數據安全方面的不同特點,有的放矢採取相應的合規和安全保護措施。

面向未來的挑战:

前所未有的數據匯聚

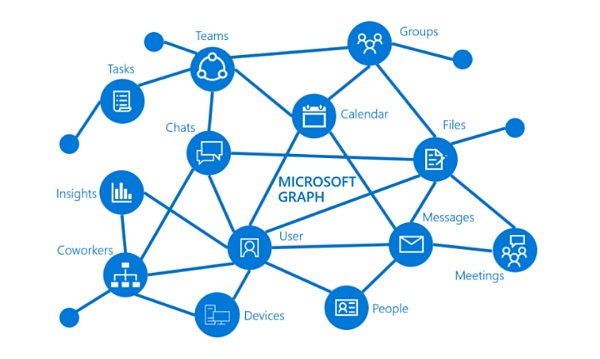

基於大語言模型的生成式AI爲世人所矚目,不在內容生成,而在其所具有的通用人工智能(Artificiall general interlligence,AGI)潛力,業界驚呼:AGI的奇點時刻正在到來。未來,除了面向普通大衆的內容生成式AI應用外,業界普遍認爲AI也將改寫互聯網範式。現有商業模式將廣泛引入AI智能模型,大幅提升用戶交互效率。這不是將來時,而是進行時。2023年3月17日,微軟發布Microsoft 365 Copilot,將大語言模型(LLM)功能與微軟辦公應用相結合,幫助用戶解鎖生產力[8]。

Copilot將會被內置到辦公全家桶內,在Word、Excel、PowerPoint中,AI將與個人通過便捷的語言交互,一起撰寫文檔,演示文稿,實現數據可視化;在Outlook,Teams ,Business Chat中,AI能夠幫助用戶回復郵件,管理郵箱,實時完成會議摘要和待辦事項,提高會議效率。

辦公效率的飛越提升,不僅建立在強大的AI模型能力基礎之上,更建立在廣泛的數據打通鏈接基礎之上,使用Copilot意味着用戶將授權微軟打通跨越各業務平台的個人數據。正如微軟隱私政策所陳述,爲實現業務提供,改進和开發產品等目的,微軟會從不同的業務環境中(例如在使用兩個以上 Microsoft 產品的過程中)收集的數據進行合並[9]。

這只是未來超級數字助理的雛形,在智能基礎設施的支持之下,每個人甚至可以擁有多個數字分身,協同完成任務。可以想見,數字助理的背後是大語言模型訪問、鏈接個人以及商業企業的私有數據,數據的融合利用一定是無縫絲滑的。此類數據的訪問處理如何以安全、合規、保護隱私的方式進行,對安全技術保障措施提出了更高要求。

圖:Microsoft Graph 是 Microsoft 365 中數據和智能的網關。它提供了統一的可編程性模型,以安全便捷地跨業務平台訪問數據。

同時,我們也迫切需要審視現有的隱私保護與合規機制。在當前移動互聯網個人信息保護實踐中,對於必要性原則解釋是非常嚴苛的,以最大程度的避免數據收集與匯聚。例如:《常見類型移動互聯網應用程序必要個人信息範圍規定》(簡稱《39類規定》)不僅針對每類應用區分了基本功能和附加功能,還針對基本功能收集的必要信息進行了明確。在大部分基本功能中僅能收集兩三類個人信息,例如定位和導航功能僅能收集位置信息、出發地、到達地三種信息;《App違法違規收集使用個人信息行爲認定方法》中更是明確:不得僅以改善服務質量、研發新產品等理由收集個人信息。這種基於“嚴防死守”的數據合規思路在未來的AI應用場景中是否還能繼續走下去,是一個值得探討的問題。

從移動互聯網到我們正在步入的AI時代,雖然數據利用一直在向更廣更深的方向發展,但各類新技術應用仍將隱私保護作爲價值對齊(value alignment)的重要方面。隱私和數據安全的真諦從來也不是對數據的使用進行各種限制,或者人爲增加數據利用門檻,而在於通過激烈的市場競爭、健全的法律機制和更加強大的技術安全措施來切實保障用戶隱私與數據安全。

參考資料來源:

[1]https://openai.com/policies/privacy-policy

[2]https://docs.midjourney.com/docs/privacy-policy

[3]https://www.gpdp.it/web/guest/home/docweb/-/docweb-display/docweb/9870832

[4]GDPR Article 58&Article 83

[5]https://www.reuters.com/technology/italys-data-watchdog-chatgpt-can-resume-april-30-if-openai-takes-useful-steps-2023-04-18/

[6]https://openai.com/blog/new-ways-to-manage-your-data-in-chatgpt

[7]https://openai.com/product/gpt-4

[8]https://news.microsoft.com/zh-cn/microsoft-365-copilot/

[9]https://privacy.microsoft.com/zh-cn/privacystatement

標題:ChatGPT類應用服務 數據合規有特殊性嗎?

地址:https://www.coinsdeep.com/article/12876.html

鄭重聲明:本文版權歸原作者所有,轉載文章僅為傳播信息之目的,不構成任何投資建議,如有侵權行為,請第一時間聯絡我們修改或刪除,多謝。