AI on AO 發布會:AO協議的三大AI技術突破

發表於 2024-06-21 11:16 作者: 金色精選

AI on AO 發布會:AO協議的三大AI技術突破

金色精選

金色官方

剛剛

金色精選

金色官方

剛剛

作者:Kyle_13,來源:作者推特@kylewmi

感謝今天各位的到來。我們有一系列關於 AO 技術的超級令人興奮的進展要與大家分享。我們會先進行一個演示,然後 Nick 和我會在這裏嘗試構建一個 AI 代理,這個代理將在智能合約中使用大型語言模型,基於你們即將聽到的系統中的聊天情緒進行买賣。今天我們將現場從頭开始構建它,希望一切順利。

是的,你們將看到如何自己做這一切。

這裏的技術進步確實讓 AO 遠遠超越了其他智能合約系統。這在以前已經是事實,現在它越來越像一個去中心化的超級計算機,而不是傳統的智能合約網絡。但它具備了智能合約網絡的所有特性。因此,我們非常激動地與大家分享這一切。事不宜遲,讓我們开始演示,然後我們會進行討論,並且我們將一起現場構建一些東西。

大家好,感謝今天的到來。我們非常激動地宣布 AO 協議的三項重大技術更新。它們共同實現了一個大目標,即支持在去中心化環境中運行的大型語言模型作爲智能合約的一部分。這些不僅僅是玩具模型,小模型,或者被編譯成自己二進制文件的模型。

這是一個完整的系統,可以讓你運行幾乎所有當前开源和可用的主要模型。比如 Llama 3 在鏈上運行在智能合約中,GPT 也是如此,還有蘋果的模型等等。這是整個生態系統共同努力的成果,有三項主要的技術進步也構成了這個系統的一部分。因此,我非常激動地向大家介紹這一切。

大體情況是,現在 LLM(大型語言模型)可以在智能合約中運行。你可能多次聽說去中心化 AI 和 AI 加密貨幣。實際上,除了一種我們今天要討論的系統外,幾乎所有這些系統都是作爲預言機的 AI,也就是在鏈下運行 AI,然後將執行結果放到鏈上,用於下遊的某些用途。

我們說的不是這個。我們說的是將大型語言模型推理作爲智能合約狀態執行的一部分。這一切都得益於我們擁有的 AO 硬盤以及 AO 的超並行處理機制,這意味着你可以運行大量的計算,而這不會影響我正在使用的不同進程。我們認爲,這將允許我們創建一個非常豐富的去中心化自主代理金融系統。

到目前爲止,在去中心化金融(DeFi)中,我們基本上已經能夠使原始交易的執行變得無需信任。在不同經濟遊戲中的交互,比如借貸和交換,都是無需信任的。這只是問題的一個方面。如果你考慮全球金融市場。

是的,有各種不同的經濟原件在不同方式中發揮作用。有債券、股票、商品和衍生品等等。但我們真正談論市場時,不僅僅是這些,實際上是智能層。是決定买賣、借貸或參與各種金融遊戲的人。

到目前爲止,在去中心化金融生態系統中,我們成功地將所有這些原件轉移到一個無需信任的狀態中。因此,你可以在 Uniswap 上進行交換,而不需要信任 Uniswap 的運營者。實際上,從根本上講,沒有運營者。市場的智能層被留在了鏈下。所以,如果你想參與加密貨幣投資,而不想自己做所有研究和參與,你必須找到一個基金。

你可以信任他們的資金,然後他們去執行智能決策,並將其下遊傳遞到網絡本身的基本原件執行中。我們認爲,在 AO 中,我們實際上已經具備了將市場的智能部分,即導致決策的智能,轉移到網絡本身的能力。因此,一個簡單的理解方式可能是想象一下。

一個你可以信任的對衝基金或投資組合管理應用程序,可以在網絡內執行一組智能指令,從而將網絡的無需信任性轉移到決策過程中。這意味着一個匿名账戶,例如 Yolo 420 Trader Number One(一個大膽、隨意的交易者),可以創建一個新的有趣策略,並將其部署到網絡上,而你可以將資本投入其中而無需真正信任。

你現在可以構建與大型統計模型交互的自主代理。而最常見的大型統計模型是大型語言模型,可以處理和生成文本。這意味着你可以將這些模型放入智能合約中,作爲由某個有新穎想法的人开發的策略的一部分,並在網絡中智能地執行它們。

你可以想象做一些基礎的情緒分析。比如你讀取新聞,決定這是买賣這個衍生品的好時機。這是執行這種或那種操作的好時機。你可以讓類似人類的決策以無需信任的方式執行。這不僅僅是理論。我們創建了一個有趣的迷因幣,稱爲 Llama Fed。基本上這個想法是,它是一個法幣模擬器,其中的一群 llama(羊駝)由 Llama 3 模型表示。

它們就像 llama 和美聯儲主席的結合體,你可以去找它們,請求它們發放一些代幣,它們會評估你的請求。大型語言模型本身操作貨幣政策,完全自主、無需信任。我們構建了它,但我們無法控制它。它們操作貨幣政策,決定誰應該獲得代幣,誰不應該。這是這一技術的一個非常有趣的小應用,希望能激發生態系統中所有其他可能的應用。

爲了實現這一點,我們必須爲 AO 創建三種新的基礎能力,其中一些在基礎協議層,另一些在應用層。這不僅對大型語言模型的執行有用,對 AO 开發者來說更爲廣泛和激動人心。所以我很高興今天能向大家介紹這些。

這些新技術中的第一個是 Web Assembly 64 位支持。聽起來有點像技術術語,但我有辦法讓每個人都理解它的意義。從根本上講,Web Assembly 64 支持允許开發人員創建使用超過 4GB 內存的應用程序。稍後我們會介紹新的限制,它們相當驚人。

如果你不是开發人員,可以這樣理解:有人讓你寫一本書,你對這個想法很興奮,但他們說你只能寫 100 頁。不多不少。你可以表達書中的想法,但無法以自然和正常的方式進行,因爲有外部限制,你必須迎合它,改變你的寫作方式以適應它。

如果你不是开發人員,可以這樣理解:有人讓你寫一本書,你對這個想法很興奮,但他們說你只能寫 100 頁。不多不少。你可以表達書中的想法,但無法以自然和正常的方式進行,因爲有外部限制,你必須迎合它,改變你的寫作方式以適應它。

在智能合約生態系統中,這不僅僅是 100 頁的限制。我會說這有點像在早期版本的 AO 中構建。以太坊有 48KB 的內存限制,就像有人讓你寫一本只有一句話長的書,而且你只能使用前 200 個最流行的英語單詞。在這個系統中構建真正令人興奮的應用程序極其困難。

然後是 Solana,你可以訪問 10MB 的工作內存。這顯然是一個改進,但基本上我們說的是一頁紙。ICP,互聯網計算機協議,允許支持 3GB 的內存。理論上是完整的,但他們不得不降低到 3GB。現在有了 3GB 的內存,你可以運行很多不同的應用程序,但你肯定不能運行大型 AI 應用程序。它們需要加載大量數據到主內存,以便快速訪問。這在 3GB 內存中無法有效地實現。

當我們在今年二月份發布 AO 時,我們也有 4GB 內存限制,這實際上源自 Web Assembly 32。現在,這個內存限制在協議層面完全消失了。相反,協議層面的內存限制是 18EB(艾字節)。這是一個巨大的存儲量。

直到這在內存中用於計算而不是長期存儲介質之前,會需要相當長的時間。在實現層面,AO 網絡中的計算單元,現在能夠訪問 16GB 內存,但在未來無需更改協議就可以將其替換爲更大容量的內存,這將相對容易。16GB 已經足夠運行大型語言模型計算,這意味着你今天可以在 AO 上下載和執行 16GB 的模型。比如 Llama 3 未量化版本的 Falcon 3 以及許多其他模型。

這是構建智能語言基礎計算系統所必需的核心組件。現在它作爲智能合約的一部分在鏈上完全支持,我們認爲這是非常非常令人興奮的。

這消除了 AO 以及隨後智能合約系統的一大主要計算限制。當我們在今年二月發布 AO 時,你可能會注意到視頻中我們多次提到你有無限的計算能力,但有一個限制,就是不能超過 4GB 內存。這就是那個限制的解除。我們認爲這是一個非常令人興奮的進步,16GB 已經足夠運行當前 AI 領域幾乎所有你想運行的模型。

我們能夠在不更改協議的情況下提升 16GB 限制,未來這將相對容易,與最初運行 Web Assembly 64 相比,這是一大進步。因此,這本身就是系統能力的巨大進步。第二個使大型語言模型能夠在 AO 上運行的主要技術是 WeaveDrive。

WeaveDrive 讓你可以像本地硬盤一樣訪問 AO 內的 Arweave 數據。這意味着你可以打开 AO 中任何經過調度單元認證的事務 ID 並上傳到網絡。當然,你可以訪問這些數據並將其讀入你的程序中,就像本地硬盤上的文件一樣。

我們都知道,目前 Arweave 上存儲了大約 60 億條事務數據,所以這是一個巨大的數據集起點。這也意味着在未來構建應用程序時,上傳數據到 Arweave 的動機會增加,因爲這些數據也可以在 AO 程序中使用。例如,當我們使大型語言模型在 Arweave 上運行時,我們大約上傳了價值 1000 美元的模型到網絡上。但這只是开始。

有了本地文件系統的智能合約網絡,你可以構建的應用程序數量是巨大的。因此,這非常令人興奮。更好的是,我們構建的系統允許你將數據流式傳輸到執行環境中。這是一個技術上的細微差別,但你可以想象回到書的類比中。

有人對你說,我想訪問你這本書中的一個數據。我想獲取這本書中的一個圖表。在一個簡單的系統中,甚至在目前的智能合約網絡中,這都會是一個巨大的進步,你會給出整本書。然而這顯然效率不高,特別是如果那本書是一個包含數千頁的大型統計模型。

這極其低效。相反,我們在 AO 中所做的是讓你可以直接讀取字節。你直接到書中的圖表位置,只復制圖表到你的應用程序中並執行。這使得系統的效率得到了極大的提升。這不僅是一個最小可行產品(MVP),它是一個功能齊全、構建良好的數據訪問機制。因此你有一個無限計算系統和一個無限硬盤,將它們結合在一起,你就有了一台超級計算機。

這在以前從未被構建過,現在它以最低成本提供給每個人使用。這就是 AO 的現狀,我們對此非常興奮。該系統的實現也在操作系統層面。因此,我們將 WeaveDrive 變成 AO 的一個子協議,它是一個計算單元擴展,任何人都可以加載。這很有趣,因爲這是首個此類擴展。

AO 一直具備讓你爲執行環境添加擴展的能力。就像你有一台計算機,你想插入更多的內存,或者插入一張顯卡,你物理上將一個單元放入系統中。你可以對 AO 的計算單元執行此操作,這就是我們在這裏做的。因此,在操作系統層面,你現在有一個硬盤,它只是代表數據存儲的文件系統。

這意味着你不僅可以在 AO 中訪問這些數據,以通常的方式構建應用程序,但實際上你可以從任何帶到網絡上的應用程序中訪問它。因此,這是一個廣泛適用的能力,所有在系統中構建的人員都可以訪問,不論他們使用何種語言編寫,Rust、C、Lure、Solidity 等都可以訪問,像它是系統的原生功能一樣。在構建這一系統的過程中,它還迫使我們創建了子協議協議,創建其他計算單元擴展的方法,以便將來其他人也能構建激動人心的東西。

現在我們有能力在任意大小的內存集中運行計算,並能將網絡中的數據加載到 AO 內的進程中,接下來要問的是,如何進行推理本身。

由於我們選擇在 Web Assembly 上構建 AO 作爲其主要虛擬機,因此將現有代碼編譯並運行在該環境中相對容易。由於我們構建了 WeaveDrive 使其暴露爲操作系統層面的文件系統,將 Llama.cpp(一個开源的大型語言模型推理引擎)運行在系統上實際上是相對容易的。

這非常令人興奮,因爲這意味着你不僅可以運行此推理引擎,還可以輕松運行許多其他引擎。因此,使大型語言模型在 AO 內運行的最後一個組件是大型語言模型推理引擎本身。我們移植了一個名爲 Llama.cpp 的系統,聽起來有點神祕,但實際上它是當前領先的开源模型執行環境。

直接在 AO 智能合約內運行,一旦我們有能力在系統中擁有任意數量的數據,然後從 Arweave 中加載任意數量的數據,這實際上是相對容易的。

爲了實現這一點,我們還與稱爲 SIMD(單指令多數據)計算擴展合作,這使你可以更快地運行這些模型。因此我們也啓用了這一功能。這意味着目前這些模型在 CPU 上運行,但速度相當快。如果你有異步計算,它應該適合你的使用場景。像讀取新聞信號然後決定執行哪些交易,在目前的系統下運行良好。但我們也有一些令人興奮的升級將在不久後談到,關於其他加速機制,如使用 GPU 加速大型語言模型推理。

Llama.cpp 允許你加載不僅是 Meta 的領先模型 Llama 3,還可以加載許多其他模型,實際上大約 90% 以上你可以從开源模型網站 Hugging Face 下載的模型都可以在系統內運行,從 GPT-2 如果你愿意,到 253 和 Monet,蘋果自己的大型語言模型系統以及許多其他模型。因此我們現在有了框架,可以將任何模型從 Arweave 上傳,使用硬盤上傳我想在系統中運行的模型。你上傳它們,它們只是正常的數據,然後你可以加載它們到 AO 的進程中並執行,獲取結果並以你喜歡的方式工作。我們認爲這是一個包,它使在以前的智能合約生態系統中無法實現的應用程序成爲可能,即使現在可能實現,在現有系統如 Solana 中進行架構更改的數量也只是難以預料,不在其路线圖上。因此爲了向你們展示這一點並使其變得真實和易於理解,我們創建了一個模擬器 Llama Fed。基本思想是我們得到一個美聯儲成員委員會,它們是 llama,無論在作爲元 llama 3 模型還是在作爲美聯儲主席這一點上都是 llama。

我們也告訴它們它們是 llama,像 Alan Greenspan 或美聯儲主席一樣。你可以進入這個小環境。

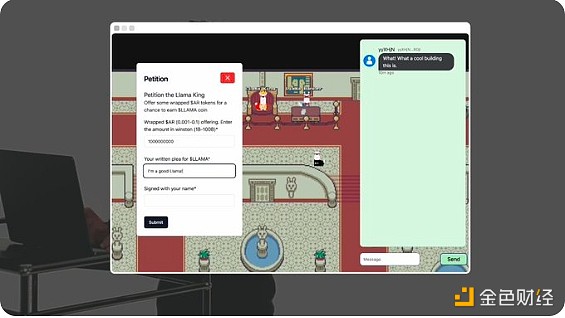

一些人會熟悉這個環境,實際上它就像我們今天工作的 Gather,你可以和 llama 交談,請求它們給予你一些代幣用於一個非常有趣的項目,並且它們會根據你的請求決定是否給予你代幣。因此你燃燒一些 Arweave 代幣,wAR 代幣(由 AOX 團隊提供),它們會根據認爲你的提案是否好給予你代幣。因此這是一個迷因幣,貨幣政策完全自主和智能化。雖然這是一種簡單形式的智能,但仍然有趣。它將評估你的提案和其他人的提案,並運行貨幣政策。通過分析新聞標題並做出智能決策或與客戶支持交互並返回價值,所有這些現在都可以在智能合約內實現。Elliot 現在將爲大家展示。

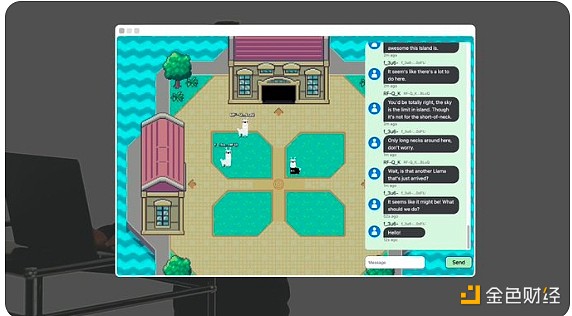

大家好,我是 Elliot,今天我要向你展示 Llama Land,這是一個在 AO 內運行的鏈上自主世界,由 Meta 的开源 Llama 3 模型驅動。

我們在這裏看到的對話不僅僅是玩家之間的對話,還有完全自主的數字 llama。

我們在這裏看到的對話不僅僅是玩家之間的對話,還有完全自主的數字 llama。

例如這個 llama 是人類。

但這個 llama 是鏈上 AI。

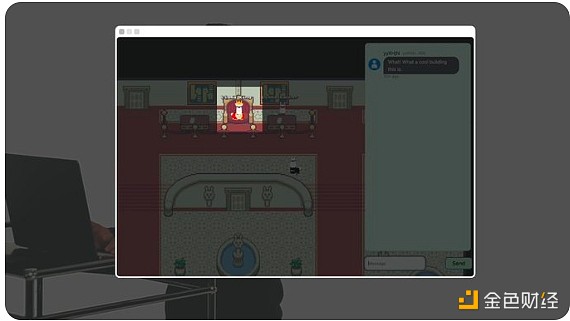

這棟建築包含了 Llama fed。它就像美聯儲,但爲 llama 服務。

Llama fed 運行世界上第一個 AI 驅動的貨幣政策,並鑄造 Llama 代幣。

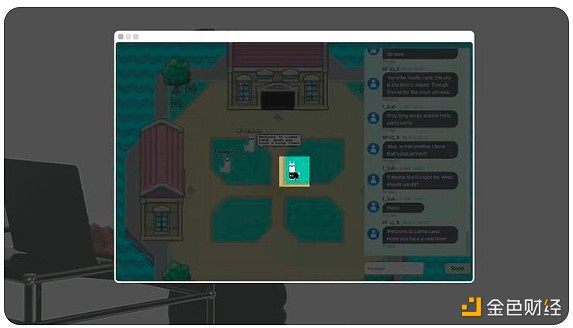

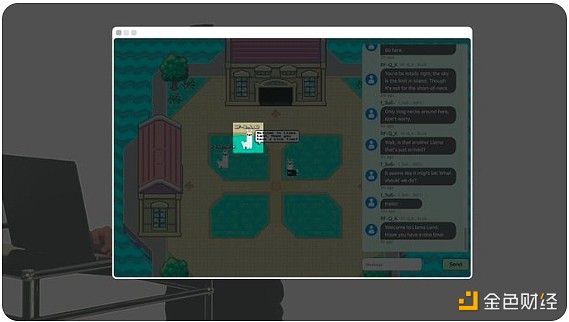

這個家夥是 Llama 國王。你可以向他提供包裝的 Arweave 代幣(wAR),並寫一個請求以獲取一些 Llama 代幣。

Llama 國王 AI 會評估並決定是否授予 Llama 代幣。Llamafed 的貨幣政策完全自主,沒有人爲監督。世界上的每個代理和每個房間本身都是 AO 上的鏈上進程。

看起來 Llama 國王授予了我們一些代幣,如果我查看我的 ArConnect 錢包,我可以看到它們已經在那裏了。不錯。Llama Land 只是第一個在 AO 上實現的 AI 驅動的世界。這是一個新協議的框架,允許任何人構建自己的自主世界,唯一的限制是你的想象力。所有這些都是 100% 鏈上實現的,只有在 AO 上才有可能。

謝謝 Elliot。你剛剛看到的不僅是一個大型語言模型參與金融決策並運行一個自主的貨幣政策系統。沒有後門,我們無法控制它,所有這些都是由 AI 本身運行的。你還看到一個小宇宙,一個你可以在物理空間中行走的地方,你可以去那個地方與金融基礎設施互動。我們認爲,這不僅是一個有趣的小演示。

實際上這裏有一些非常有趣的東西,這些地方將不同使用金融產品的人聚集在一起。我們在 DeFi 生態系統中看到,如果有人想參與一個項目,他們首先在 Twitter 上查看,然後訪問網站,參與遊戲中的基本原件。

然後他們加入 Telegram 群組或 Discord 頻道或在 Twitter 上與其他用戶交談。這種體驗非常去中心化,我們都在不同應用程序之間跳轉。我們正在嘗試的一個有趣想法是,如果你有這些 DeFi 應用程序的用戶界面,讓他們的社區可以聚集在一起並共同管理這個他們集體訪問的自主空間,因爲這是一個永久的網絡應用,可以加入體驗。

想象一下你可以去一個看起來像拍賣行的地方,和其他喜歡該協議的用戶在一起聊天。當在 AO 上發生的金融機制進程有活動時,基本上你可以和其他用戶聊天。社區和社交方面與產品的金融部分結合在一起。

我們認爲這非常有趣,甚至有更廣泛的影響。你可以在這裏構建一個自主 AI 代理,它在這個 Arweave 世界中四處遊蕩,與它發現的不同應用程序和用戶互動。所以如果你正在構建一個元宇宙,當你創建一個在线遊戲時,第一件事就是創建 NPC(非玩家角色)。在這裏,NPC 可以是通用的。

你有一個智能系統,它四處遊蕩,與環境互動,所以你沒有用戶冷啓動問題。你可以有一些自主代理,試圖爲自己賺錢,試圖交朋友,像正常的 DeFi 用戶一樣,與環境互動。我們認爲這非常有趣,雖然有點怪異。我們將拭目以待。

展望未來,我們還看到了在 AO 中加速大型語言模型執行的機會。早些時候我談到了計算單元擴展的概念。這就是我們用來構建 WeaveDrive 的方式。

不僅僅停留在 WeaveDrive,你可以爲 AO 的計算環境構建任何類型的擴展。有一個非常令人興奮的生態項目正在爲 GPU 加速大型語言模型執行解決這個問題,就是 Apus Network。我讓他們來解釋。

嗨,我是 Mateo。今天我很興奮地介紹 Apus Network。Apus Network 致力於構建去中心化的、無需信任的 GPU 網絡。

我們通過利用 Arweave 永久的鏈上存儲,提供一個开源 AO 擴展,提供 GPU 的確定性執行環境,並爲去中心化 AI 提供經濟激勵模型,使用 AO 和 APUS 代幣。Apus Network 將使用 GPU 挖礦節點競爭性地執行最優的、無需信任的模型訓練在 Arweave 和 AO 上運行。這確保了用戶可以以最具成本效益的價格使用最佳 AI 模型。你可以在 X(Twitter)@apus_network 上關注我們的進展。謝謝。

這就是今天 AO 上的 AI 現狀。你可以去試試 Llama Fed,嘗試自己構建基於大型語言模型的智能合約應用。我們認爲這是引入市場智能到去中心化執行環境的开始。我們對此非常激動,期待看到接下來會發生什么。謝謝大家今天的參與,期待再次與大家交流。

標題:AI on AO 發布會:AO協議的三大AI技術突破

地址:https://www.coinsdeep.com/article/136371.html

鄭重聲明:本文版權歸原作者所有,轉載文章僅為傳播信息之目的,不構成任何投資建議,如有侵權行為,請第一時間聯絡我們修改或刪除,多謝。